16. Introduction à MySQL Cluster▲

MySQL Cluster utilise le nouveau moteur de table NDB Cluster pour faire fonctionner plusieurs serveurs MySQL en cluster. Le code du moteur NDB Cluster est disponible dans le serveur BitKeeper de MySQL depuis la version 4.1.2 et avec les distributions binaires depuis MySQL-Max 4.1.3.

Actuellement, les systèmes d'exploitation supportés sont Linux, Mac OS X et Solaris. Nous travaillons à rendre NDB Cluster disponible sur toutes les plateformes que supporte MySQL, y compris Windows.

Ce chapitre est en cours de rédaction. Les autres documents décrivant le cluster MySQL sont disponibles à http://www.mysql.com/cluster et http://dev.mysql.com/doc.

Vous pouvez aussi vous inscrire sur la liste de diffusion du cluster MySQL. Voyez http://lists.mysql.com/.

16-1. Présentation de MySQL Cluster▲

Un Cluster MySQL est un groupe de processus qui s'exécutent sur plusieurs serveurs MySQL, des nœuds NDBCluster, et des processus d'administration, ainsi que des processus d'accès spécialisés. Tous ces programmes fonctionnent ensemble pour former un Cluster MySQL. Lorsque les données sont stockées dans le moteur NDBCluster, les tables sont réparties sur les nœuds NDBCluster. Ces tables sont directement accessibles depuis tous les autres serveurs MySQL faisant partie du Cluster. Par conséquent, si une application met à jour une ligne, tous les autres serveurs le verront immédiatement.

Les données stockées dans le moteur de table de MySQL Cluster peuvent être dupliquées, et sont capables de gérer une indisponibilité d'un nœud sans autre impact que l'annulation des transactions qui utilisaient ces données. Cela ne devrait pas être un problème, car les applications transactionnelles sont écrites pour gérer les échecs de transaction.

En plaçant MySQL Cluster en Open Source, MySQL rend les hautes performances, haute disponibilité et grands trafics accessibles à tous ceux qui en ont besoin.

16-2. Concepts de base de MySQL Cluster▲

MySQL Cluster est constitué de trois types de programmes différents :

- premièrement, un jeu de processus serveur MySQL. Ce sont des serveurs MySQL traditionnels, avec le nouveau moteur de table NDBCluster qui autorise l'accès aux tables en cluster ;

- le second type de processus est représenté par les nœuds de stockage de NDBCluster. Ces processus contiennent les données stockées dans MySQL Cluster. Les données de MySQL Cluster sont réparties entre les différents nœuds du cluster, et sont aussi doublées dans le cluster ;

- le troisième type de processus est les processus d'administration. Ces processus sont utilisés pour gérer la configuration du cluster.

Nous appelons ces processus de cluster les nœuds du cluster. Mettre en place la configuration du cluster implique la configuration de chaque nœud dans le cluster, et la configuration de chaque moyen de communication entre les nœuds du cluster. MySQL Cluster est actuellement configuré avec le prérequis que les nœuds sont homogènes en termes de puissance processeur, espace mémoire et largeur de bande. De plus, pour activer un point de configuration, il a été décidé de placer toute la configuration du cluster dans un seul fichier de configuration.

Les processus d'administration gèrent le fichier de configuration du cluster, et les logs. Tous les nœuds dans le cluster contactent le serveur d'administration pour lire leur configuration : ils doivent donc savoir où le serveur d'administration réside en premier lieu. Lorsqu'un événement pertinent survient dans un moteur de stockage, il est transféré au serveur d'administration qui l'écrit dans le log.

De plus, il y a un nombre arbitraire de clients connectés au cluster. Ils sont de deux types. D'abord, les clients MySQL normaux, qui ne sont pas spécifiques à MySQL Cluster. MySQL Cluster est accessible à partir des applications MySQL écrites en PHP, Perl, C, C++, Java, Ruby, etc. Deuxièmement, les clients d'administration. Ces clients accèdent au serveur d'administration, et émettent des commandes pour lancer ou arrêter correctement des nœuds, lancer ou arrêter la trace serveur (pour les versions de débogage), pour afficher la configuration courante, voir l'état des nœuds du cluster, afficher les versions et nœuds, lancer les sauvegardes, etc.

16-3. Configuration simple multiserveur▲

Cette section est un guide qui décrit comment planifier l'installation, configurer et faire fonctionner un cluster MySQL viable. Contrairement aux exemples de la section Section 16.4, « Configuration de MySQL Cluster »Configuration de MySQL Cluster, le résultat de ces procédures est un cluster MySQL fonctionnel, qui dispose des fonctionnalités minimales pour assurer la disponibilité et la sauvegarde des données.

Dans cette section, nous allons couvrir : le matériel et les logiciels nécessaires ; les problèmes réseau ; l'installation de MySQL et du cluster ; la configuration ; le démarrage, l'arrêt et le redémarrage du cluster MySQL ; le chargement de données dans une base d'exemple ; l'exécution de requêtes.

Hypothèses de base

Ce guide part des hypothèses suivantes.

-

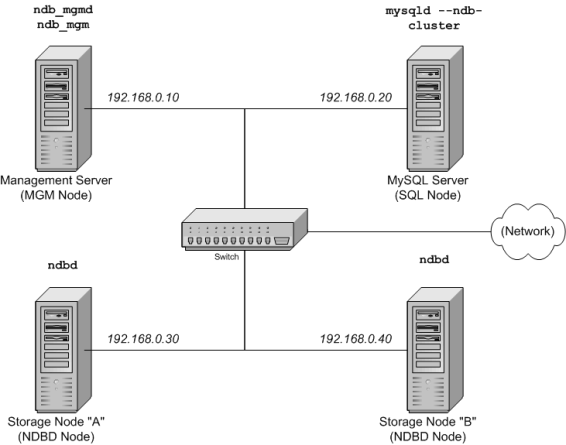

Nous allons configurer un cluster de quatre nœuds, chacun sur un hôte distinct, et chacun des hôtes étant relié au réseau avec une adresse IP fixe, via une carte Ethernet classique, comme ceci :

Nœud

Adresse IP

nœud de gestion (MGM)

192.168.0.10

Serveur MySQL (SQL)

192.168.0.20

Serveur de stockage (NDBD) « A »

192.168.0.30

Serveur de stockage (NDBD) « B »

192.168.0.40

Cela est peut-être plus clair sur le schéma suivant :

Note : par souci de simplicité et de robustesse, nous allons utiliser les adresses IP numériques dans ce guide. Cependant, si la résolution DNS est disponible sur votre réseau, il est aussi possible d'utiliser les noms d'hôtes plutôt que les IP lors de la configuration du cluster. Alternativement, vous pouvez aussi utiliser le fichier /etc/hosts de votre système d'exploitation ou son équivalent pour fournir un système de résolution de noms.

-

Chaque hôte est un ordinateur de bureau Intel, avec une distribution générique Linux sur le disque, dans une configuration standard, et sans aucun service inutile. Le cœur du système et un client standard TCP/IP doivent être suffisants. De même, par souci de simplicité, nous allons supposer que les systèmes de fichiers des hôtes sont tous identiques. Dans le cas où ils ne le sont pas, vous devrez adapter les instructions en fonction des situations.

-

Des cartes 100 mégabits ou gigabits Ethernet sont installées sur chaque machine, avec les bons pilotes pour les cartes, et chaque hôte est connecté au réseau via un routeur standard, comme un switch. Toutes les machines doivent utiliser des cartes avec le même débit, c'est-à-dire que toutes les machines du cluster sont en 100 mégabits, ou bien en gigabit. Le cluster MySQL fonctionnera sur un réseau 100 mégabits, mais les cartes gigabit fourniront de meilleures performances.

Notez que le cluster MySQL n'est pas prévu pour fonctionner sur un réseau avec une connectivité inférieure à 100 mégabits. Pour cette raison, entre autres, faire fonctionner un cluster MySQL sur un réseau public ou via Internet risque de ne pas réussir, et n'est pas recommandé. - Pour les données de tests, nous allons utiliser la base de données world qui est disponible en téléchargement sur le site de MySQL AB. Comme cette base de données prend peu d'espace, nous pouvons fonctionner avec des machines ayant 256 Mo de RAM, ce qui doit être suffisant pour le système d'exploitation, les processus NDB et le stockage dans les nœuds.

Même si nous faisons référence à Linux comme système d'exploitation dans ce guide, les instructions et les procédures sont faciles à adapter pour Solaris ou Mac OS X. Nous supposons aussi que vous savez faire une installation minimale et la configuration du système d'exploitation en réseau, ou que vous disposez d'assistance pour ce faire.

Nous allons présenter les besoins en matériel, logiciels et réseau pour le cluster MySQL dans la prochaine section. Voyez Section 16.3.1, « Matériel, logiciels et réseau »Matériel, logiciels et réseau.

16-3-1. Matériel, logiciels et réseau▲

Une des forces du Cluster MySQL est qu'il peut fonctionner sur n'importe quel serveur, et n'a pas de prérequis particulier, en dehors d'une grande quantité de mémoire vive, due au fait que toutes les données sont stockées en mémoire. Notez que cela pourrait changer à l'avenir, et que nous travaillons à avoir un stockage sur disque dans les prochaines versions du Cluster MySQL. Naturellement, les machines multiprocesseurs et celles aux fréquences supérieures seront plus rapides. Les besoins en RAM des processus du Cluster MySQL sont relativement raisonnables.

Les besoins en logiciels pour le Cluster MySQL sont aussi modestes. Les systèmes d'exploitation hôtes n'ont pas besoin de modules particuliers, ni services, ni applications ou configurations pour supporter Cluster MySQL. Pour Mac OS X ou Solaris, l'installation standard est suffisante. Pour Linux, une installation standard de base doit être suffisante. Les prérequis pour MySQL sont simples : tout ce qui est nécessaire pour faire fonctionner MySQL-max 4.1.3 ou plus récent ; vous devez utiliser la version -max de MySQL pour avoir le support du Cluster MySQL. Il n'est pas nécessaire de compiler MySQL vous-même pour être en mesure d'exécuter le Cluster MySQL. Dans cette documentation, nous allons supposer que vous utilisez le binaire -max adapté à votre système, disponible via la page de téléchargements de MySQL : http://dev.mysql.com/downloads.

Pour les communications entre les nœuds, Cluster MySQL supporte le protocole TCP/IP pour toutes les topologies, et le minimum attendu pour chaque hôte est une carte Ethernet 100 mégabits, plus un switch, hub ou routeur pour fournir la connectivité entre les parties du Cluster. Nous recommandons vivement que le Cluster MySQL dispose de son propre masque de sous-réseau pour les raisons suivantes.

- Sécurité : les communications entre les nœuds du Cluster MySQL ne sont pas chiffrées ou protégées de quelque manière que ce soit. La seule solution pour protéger les transmissions à l'intérieur du Cluster MySQL est de placer le Cluster MySQL dans un réseau protégé. Si vous envisagez d'utiliser le Cluster MySQL pour une application Web, il est recommandé que le Cluster MySQL soit placé derrière un pare-feu, et non pas dans la zone démilitarisée (DMZ) ou ailleurs.

- Efficacité : configurer un Cluster MySQL sur un réseau privé ou protégé donne au Cluster MySQL l'exclusivité de la bande passante. En utilisant un switch dédié au Cluster MySQL aide à la protection contre les accès non autorisés, et il protège les nœuds des interférences causées par les autres machines sur le réseau. Pour une stabilité accrue, vous pouvez utiliser des switchs redondants et des cartes réseau doubles pour supprimer du réseau les points de panne : de nombreux pilotes réseau savent s'adapter si une panne survient sur un brin de réseau.

Il est aussi possible d'utiliser l'interface SCI (Scalable Coherent Interface à haute vitesse, avec le Cluster MySQL, mais ce n'est pas nécessaire. Voyez Section 16.7, « Utilisation d'interconnexions haute vitesse avec MySQL Cluster »Utilisation d'interconnexions haute vitesse avec MySQL Cluster pour plus d'informations sur ce protocole et ses utilisations avec Cluster MySQL.

16-3-2. Installation▲

Chaque hôte du cluster MySQL qui héberge un nœud de stockage ou un nœud SQL doit être installé avec MySQL-max. Pour les nœuds de gestion, il n'est pas nécessaire d'installer un serveur MySQL, mais vous devez installer un démon MGM et les clients ndb_mgmd et ndb_mgm, respectivement. Dans cette section, nous allons voir les étapes nécessaires pour installer correctement chaque serveur pour un nœud du cluster.

Au moment de l'écriture de cette section, les versions les plus récentes étaient MySQL 4.1.10a ; si une version plus récente est disponible, il est recommandé de l'installer et d'utiliser ce numéro de version dans tout le reste de la section. MySQL fournit des serveurs précompilés, et il n'y a généralement pas besoin de compiler par vous-même. Si vous voulez faire une compilation personnalisée, voyez Section 2.4.3, « Installer à partir de l'arbre source de développement ». Par conséquent, la première étape de l'installation de chaque hôte du cluster est de télécharger le fichier mysql-max-4.1.10a-pc-linux-gnu-i686.tar.gz depuis MySQL downloads area. Nous supposons que vous l'avez fait, et installé dans le dossier /var/tmp de chaque machine.

Des RPM sont aussi disponibles pour les plateformes 32 et 62 bits; depuis MySQL 4.1.10a, les serveurs MySQL-max installés via RPM supportent les clusters NDB. Si vous choisissez d'utiliser ces outils plutôt que les fichiers binaires, assurez-vous d'installer à la fois les paquets -serveur et -max sur toutes les machines qui hébergent des nœuds du cluster. Voyez LinuxInstallation du logiciel pour plus d'informations sur l'installation de MySQL en RPM. Après l'installation des RPM, vous devez toujours configurer le cluster, tel que présenté dans Section 16.3.3, « Configuration »Configuration.

Note : après l'installation, ne lancez pas encore les logiciels. Nous allons vous montrer comment le faire, alors suivez d'abord la configuration des nœuds.

Installation des nœuds de stockage et SQL

Pour chacune des machines désignées pour être des hôtes de stockage ou des hôtes SQL, suivez les étapes suivantes, en tant que super utilisateur :

-

Vérifiez vos fichiers /etc/passwd et /etc/group ou utilisez les outils systèmes dont vous disposez pour gérer les groupes et utilisateurs pour vérifier si vous avez un groupe mysql et un utilisateur mysql sur votre système : certaines distributions les créent automatiquement lors de leur installation. Si ces comptes n'existent pas, alors créez un groupe mysql et un utilisateur mysql, comme ceci :

Sélectionnezgroupadd mysql useradd -g mysql mysql -

Placez-vous dans le dossier qui contient le fichier téléchargé; décompressez l'archive ; créez un lien symbolique vers l'exécutable mysql-max :

Sélectionnezcd /var/tmp tar -xzvf -C /usr/local/bin mysql-max-4.1.10a-pc-linux-gnu-i686.tar.gz ln -s /usr/local/bin/mysql-max-4.1.10a-pc-linux-gnu-i686 mysql -

Placez-vous dans le dossier mysql, et exécutez le script fourni pour la création des bases de données système :

Sélectionnezcd mysql scripts/mysql_install_db --user=mysql -

Donnez les droits nécessaires au serveur MySQL et au dossier de données :

Sélectionnezchown -R root . chown -R mysql data chgrp -R mysql .Notez que le dossier de données de chaque machine qui héberge un nœud de stockage est /usr/local/mysql/data. Nous allons utiliser cette information lors de la configuration du nœud de gestion. Voyez Section 16.3.3, « Configuration »Configuration ;

- Copiez le script de démarrage MySQL dans le dossier approprié, rendez-le exécutable, et configurez-le pour qu'il s'exécute lorsque le système d'exploitation démarre :

cp support-files/mysql.server /etc/rc.d/init.d/

chmod +x /etc/rc.d/init.d/mysql.server

chkconfig --add mysql.serverIci, nous utilisons la commande de Red Hat chkconfig pour créer les liens vers les scripts de démarrage ; utilisez les moyens appropriés pour faire la même chose sur votre système d'exploitation, tel que update-rc.d sur Debian.

N'oubliez pas que ces listes d'instructions doivent être exécutées séparément sur chaque machine qui sera un nœud de stockage ou un nœud SQL.

Installation du nœud de gestion

Pour le nœud MGM (serveur de gestion), il n'est pas nécessaire d'installer mysqld, mais seulement le serveur MGM et les clients, qui sont disponibles dans l'archive -max. Encore une fois, nous supposons que vous avez placé de fichier dans le dossier /var/tmp. En tant que root (c'est-à-dire, après avoir exécuté la commande su root ou l'équivalent sur votre système pour se faire attribuer les droits de super utilisateur), effectuez les commandes suivantes pour installer ndb_mgmd et ndb_mgm sur l'hôte de gestion :

-

Allez dans le dossier /var/tmp et décompressez ndb_mgm et ndb_mgmd de l'archive, dans un dossier approprié, comme /usr/local/bin :

Sélectionnezcd /var/tmp tar -zxvf mysql-max-4.1.10a-pc-linux-gnu-i686.tar.gz /usr/local/bin '*/bin/ndb_mgm*' - Placez-vous dans le dossier où vous avez décompressé les fichiers, puis rendez-les tous les deux exécutables :

cd /usr/local/bin

chmod +x ndb_mgm*Dans Section 16.3.3, « Configuration »Configuration, nous allons créer et configurer les fichiers pour tous les nœuds du cluster d'exemple.

16-3-3. Configuration▲

Pour notre MySQL Cluster de quatre nœuds et quatre hôtes, nous aurons besoin de préparer quatre fichiers de configuration, un par hôte/nœud.

- Chaque nœud de stockage ou nœud SQL a besoin d'un fichier my.cnf qui fournit deux informations : une chaîne connectstring qui indique au nœud où trouver le nœud MGM, et une ligne indiquant au serveur MySQL de cet hôte de fonctionner en mode NDB.

Pour plus d'informations sur les chaînes de connexion, voyez Section 16.4.4.2, « La chaîne connectstring du Cluster MySQL »La chaîne connectstring du Cluster MySQL. - Le nœud de gestion a besoin d'un fichier config.ini qui indique combien de répliques doivent être gérées, combien de mémoire allouer pour les données et les index sur chaque nœud de stockage, où trouver les nœuds de stockage, où les données seront sauvées sur le disque, et où trouver les nœuds SQL.

Configurer les nœuds de stockage et SQL

Le fichier my.cnf destiné aux nœuds de stockage est plutôt simple. Le fichier de configuration doit être placé dans le dossier /etc et peut être édité ou créé avec n'importe quel éditeur fichier. Par exemple :

vi /etc/my.cnfPour chaque nœud de stockage et chaque nœud SQL de notre exemple, le fichier my.cnf doit ressembler à ceci :

[MYSQLD] # Options du processus mysqld

ndbcluster # Fonctionne en mode NDB

ndb-connectstring=192.168.0.10 # Situation du nœud MGM

[MYSQL_CLUSTER] # Options pour le processus ndbd

ndb-connectstring=192.168.0.10 # Situation du nœud MGMAprès la saisie des données ci-dessus, sauvez ce fichier et quittez l'éditeur de texte. Faites cela pour les nœuds de stockages « A » et « B », et le nœud SQL.

Configuration du nœud de gestion

La première étape de configuration du nœud MGM est la création du dossier dans lequel le fichier de configuration sera placé, et d'y créer le fichier lui-même. Par exemple, lors d'un fonctionnement root :

mkdir /var/lib/mysql-cluster

cd /var/lib/mysql-cluster

vi config.iniNous présentons ici la commande vi utilisée pour créer le fichier, mais n'importe quel autre éditeur texte fonctionne aussi bien.

Pour notre configuration d'exemple, config.ini doit contenir les informations suivantes.

[NDBD DEFAULT] # Options affectant les processus ndbd processes sur tous les nœuds

NoOfReplicas=2 # Nombre de répliques

DataMemory=80M # Mémoire à allouer pour le stockage des données

IndexMemory=52M # Mémoire à allouer pour le stockage des index

# Pour DataMemory et IndexMemory, nous avons utilisé les

# valeurs par défaut. Comme la base de données "world"

# ne prend que 500KB, cela devrait être suffisant pour notre

# exemple de Cluster

[TCP DEFAULT] # Options TCP/IP

portnumber=2202 # Ceci est la valeur par défaut. Cependant, nous pourrions

# utiliser un port libre pour les autres hôtes du cluster.

# Note : il est recommandé avec MySQL 5.0 de ne pas spécifier

# de port, et de laisser la valeur par défaut.

[NDB_MGMD] # Options de gestion des processus :

hostname=192.168.0.10 # Nom d'hôte ou adresse IP du nœud MGM

datadir=/var/lib/mysql-cluster # Dossier des fichiers de logs du nœud MGM

[NDBD] # Options pour le stockage du nœud "A" :

# (une section [NDBD] par nœud de stockage)

hostname=192.168.0.30 # Nom d'hôte ou adresse IP

datadir=/usr/local/mysql/data # Dossier pour les fichiers de données du nœud

[NDBD] # Options pour le stockage du nœud "B" :

hostname=192.168.0.40 # Nom d'hôte ou adresse IP

datadir=/usr/local/mysql/data # Dossier pour les fichiers de données du nœud

[MYSQLD] # Options des nœuds SQL :

hostname=192.168.0.20 # Nom d'hôte ou adresse IP

datadir=/usr/local/mysql/data # Dossier pour les fichiers SQL du nœud

# (Les connexions mysqld supplémentaires peuvent

# être spécifiées pour ce nœud pour différents

# objectifs, comme l'exécution de ndb_restore)NOTE : la base de données « world » peut être téléchargée sur le site http://dev.mysql.com/doc/, rangé dans la section d'exemples : Examples.

Une fois que tous les fichiers de configuration ont été créés et que ces options minimales ont été spécifiées, vous êtes prêts à lancer le cluster MySQL et à vérifier que les processus fonctionnent. La présentation de cette étape est faite dans Section 16.3.4, « Démarrage initial »Démarrage initial.

Pour plus de détails sur les paramètres de configuration du cluster MySQL, voyez Section 16.4.4, « Fichier de configuration »Fichier de configuration et Section 16.4, « Configuration de MySQL Cluster »Configuration de MySQL Cluster. Pour la configuration du Cluster MySQL au sujet des sauvegardes, voyez Section 16.6.4.4, « Configuration pour la sauvegarde du Cluster »Configuration pour la sauvegarde du Cluster.

Note : le port par défaut pour le nœud de gestion du Cluster MySQL est le 1186, le port par défaut pour les nœuds de stockage est 2202.

16-3-4. Démarrage initial▲

Démarrer le cluster n'est pas très difficile une fois qu'il a été configuré. Chaque nœud doit être lancé séparément, et depuis l'hôte sur lequel il réside. Même s'il est possible de lancer les nœuds dans n'importe quel ordre, il est recommandé de lancer le serveur d'administration en premier, puis les nœuds de stockage et enfin, les nœuds SQL :

-

Sur l'hôte de gestion, utilisez la commande suivante depuis le Shell pour lancer le processus de gestion :

Sélectionnezshell>ndb_mgmd -f /var/lib/mysql-cluster/config.iniNotez que ndb_mgmd doit recevoir le nom et chemin du fichier de configuration, avec l'option -f ou --config-file. Voyez Section 16.5.3, « ndb_mgmd, le serveur de gestion »ndb_mgmd, le serveur de gestion pour plus de détails ;

-

Sur chaque hôte de stockage, exécutez cette commande pour lancer les processus NDBD :

Sélectionnezshell>ndbd --initialNotez qu'il est très important d'utiliser le paramètre --initial uniquement lors du premier démarrage de ndbd, ou lors du redémarrage après une opération de restauration des données ou de modification de configuration. En effet, ce paramètre va forcer le nœud à effacer les fichiers créés par les anciennes instances de ndbd, y compris les fichiers de log ;

- Sur les hôtes SQL, exécutez une commande mysqld classique :

shell> mysqld &Si tout se passe bien, et que le cluster a été correctement configuré, il devrait être opérationnel à nouveau. Vous pouvez tester cela en utilisant la commande ndb_mgm, c'est-à-dire le client de gestion ; le résultat devrait être similaire à celui-ci :

shell> ndb_mgm

-- NDB Cluster -- Management Client --

ndb_mgm> show

Connected to Management Server at: localhost:1186

Cluster Configuration

---------------------

[ndbd(NDB)] 2 node(s)

id=2 @192.168.0.30 (Version: 4.1.11, Nodegroup: 0, Master)

id=3 @192.168.0.40 (Version: 4.1.11, Nodegroup: 0)

[ndb_mgmd(MGM)] 1 node(s)

id=1 @192.168.0.10 (Version: 4.1.11)

[mysqld(SQL)] 1 node(s)

id=4 (Version: 4.1.11)Vous pouvez rencontrer diverses adaptations en fonction des versions exactes de MySQL que vous utilisez.

Note : si vous utilisez une ancienne version de MySQL, vous pourriez voir les nœuds SQL référencés sous le nom '[mysqld(API)]'. C'est une ancienne pratique qui n'a plus cours.

Vous êtes maintenant prêts à utiliser vos bases de données, vos tables et vos données dans le cluster MySQL. Voyez Section 16.3.5, « Charger les données d'exemple et exécuter des requêtes »Charger les données d'exemple et exécuter des requêtes pour aller plus loin.

16-3-5. Charger les données d'exemple et exécuter des requêtes▲

Travailler avec le cluster MySQL n'est pas différent de travailler avec un serveur MySQL classique. Il y a deux points importants à garder en tête.

-

Les tables doivent être créées avec le moteur ENGINE=NDB ou ENGINE=NDBCLUSTER, ou doivent être modifiées avec

ALTERTABLEpour qu'elles utilisent le moteur NDB, afin qu'elles soient gérées par le cluster. Si vous importez des tables depuis une base de données existante en utilisant le résultat de mysqldump, vous pouvez ouvrir le script SQL dans un éditeur de texte, et ajoutez cette option à toutes les créations de tables, ou bien remplacez les optionsENGINEouTYPE) avec l'une des valeurs ci-dessous. Par exemple, en supposant que vous utilisez la base world dans un autre serveur MySQL, qui ne supporte pas le cluster MySQL, et que vous voulez exporter la définition de la table CITY :Sélectionnezshell>mysqldump --add-drop-table world City>city_table.sqlLe résultat du fichier city_table.sql contient la commande de création de la table et les commandes d'insertion

INSERTpour importer les données dans la table :SélectionnezDROPTABLEIFEXISTSCity;CREATETABLECity(IDint(11)NOTNULLauto_increment,Namechar(35)NOTNULLdefault'', CountryCodechar(3)NOTNULLdefault'', Districtchar(20)NOTNULLdefault'', Populationint(11)NOTNULLdefault'0',PRIMARYKEY(ID))TYPE=MyISAM;INSERTINTOCityVALUES(1,'Kabul','AFG','Kabol',1780000);INSERTINTOCityVALUES(2,'Qandahar','AFG','Qandahar',237500);INSERTINTOCityVALUES(3,'Herat','AFG','Herat',186800);# (remaining INSERT statements omitted)Vous devez vous assurer que MySQL utilise le moteur NBD pour cette table. Il y a deux moyens pour le faire. L'un d'eux, avant l'importation des données dans la table, consiste à modifier la définition de la table pour qu'elle corresponde à ceci (toujours en utilisant la table City) :

SélectionnezDROPTABLEIFEXISTSCity;CREATETABLECity(IDint(11)NOTNULLauto_increment,Namechar(35)NOTNULLdefault'', CountryCodechar(3)NOTNULLdefault'', Districtchar(20)NOTNULLdefault'', Populationint(11)NOTNULLdefault'0',PRIMARYKEY(ID))ENGINE=NDBCLUSTER;INSERTINTOCityVALUES(1,'Kabul','AFG','Kabol',1780000);INSERTINTOCityVALUES(2,'Qandahar','AFG','Qandahar',237500);INSERTINTOCityVALUES(3,'Herat','AFG','Herat',186800);# (etc.)Cela doit être fait pour la définition de chaque table qui fait partie de la base de données en cluster. Le plus simple pour faire cela est de faire un rechercher/remplacer dans le fichier world.sql et de remplacer toutes les instances de

TYPE=MyISAM parENGINE=NDBCLUSTER. Si vous ne voulez pas modifier ce fichier, vous pouvez aussi utiliser la commandeALTERTABLE; voyez plus bas pour les spécificités.En supposant que vous avez déjà créé la base de données appelée world sur le nœud SQL du cluster, vous pouvez utiliser l'utilitaire de ligne de commande mysql pour lire le fichier city_table.sql, et créer puis remplir la table, comme ceci :

Sélectionnezshell>mysql world<city_table.sqlIl est très important de garder en tête que les commandes ci-dessus doivent être exécutées sur l'hôte où le nœud SQL tourne : dans ce cas, sur la machine avec l'adresse IP 192.168.0.20.

Pour créer une copie de la base de données world sur le nœud SQL, sauvez le fichier dans /usr/local/mysql/data, puis exécutez ces commandes :

Sélectionnezshell>cd /usr/local/mysql/data shell>mysql world<world.sqlBien sûr, le script SQL doit être lisible par l'utilisateur mysql. Si vous sauvez le fichier à un autre endroit, ajustez les chemins dans les commandes ci-dessus.

Exécuter les commandes SELECT sur un nœud SQL n'est pas différent de les exécuter sur une autre instance de serveur MySQL. Pour exécuter les requêtes SQL en ligne de commande, vous devez vous identifier sur le serveur, comme d'habitude :

Sélectionnezshell>mysql -u root -p Enter password: Welcome to the MySQL monitor. Commands end with ; or \g. Your MySQL connection id is1to server version:4.1.9-max Type'help;'or'\h'forhelp. Type'\c'to clear the buffer. mysql>Si vous n'avez pas modifié les clauses ENGINE= dans les définitions de tables, vous pouvez alors utiliser ces commandes :

Sélectionnezmysql>USEworld; mysql>ALTERTABLECityENGINE=NDBCLUSTER; mysql>ALTERTABLECountryENGINE=NDBCLUSTER; mysql>ALTERTABLECountryLanguageENGINE=NDBCLUSTER;Notez que nous avons simplement utilisé le compte d'administrateur par défaut, sans mot de passe. Bien entendu, dans un environnement de production, il est recommandé de toujours suivre les précautions de sécurité, y compris l'utilisation d'un mot de passe robuste pour le super utilisateur, et la création d'un compte spécifique, avec uniquement les droits nécessaires aux tâches incombantes. Pour plus de détails, voyez la section Section 5.5, « Règles de sécurité et droits d'accès au serveur MySQL ».

Il est à noter que les nœuds du cluster n'utilisent pas les droits d'accès MySQL lorsqu'ils se connectent l'un à l'autre : modifier ces droits n'a pas d'effet sur les communications entre les nœuds.

Sélectionner la base de données et exécuter une requête

SELECTsur une table se fait comme d'habitude :Sélectionnezmysql>USEworld; mysql>SELECTName, PopulationFROMCityORDERBYPopulationDESCLIMIT5;+-----------+------------+|Name|Population|+-----------+------------+|Bombay|10500000||Seoul|9981619||São Paulo|9968485||Shanghai|9696300||Jakarta|9604900|+-----------+------------+5rowsinset(0.34sec)mysql>\q Bye shell>Les applications qui reposent sur MySQL peuvent utiliser l'API standard. Il est important de penser à ce que votre application doit se connecter à un nœud SQL, et non pas aux nœuds de stockage ou au serveur de gestion. Cet exemple montre comment vous pourriez exécuter une requête en utilisant l'extension mysqli de PHP 5, sur un serveur Web :

Sélectionnez<!DOCTYPE HTML PUBLIC"-//W3C//DTD HTML 4.01 Transitional//EN""http://www.w3.org/TR/html4/loose.dtd"><html><head><meta http-equiv="Content-Type"content="text/html; charset=iso-8859-1"><title>Sélection de données avec mysqli</title></head><body><?php# Connexion au nœud SQL :$link=newmysqli('192.168.0.20','root','','world');# Les paramètres pour le constructeur mysqli sont :# hote, utilisateur, mot de passe, base de donnéesif( mysqli_connect_errno() ){die("Connexion échouée : ".mysqli_connect_error());}$query="SELECT Name, PopulationFROM CityORDER BY Population DESCLIMIT 5";# s'il n'y a pas d'erreurif($result=$link->query($query) ){?><tableborder="1"width="40%"cellpadding="4"cellspacing="1"><tbody><tr><thwidth="10%">Ville</th><th>Population</th></tr><?php// Affichage du résultatwhile($row=$result->fetch_object()) printf(<tr>\n<td align=\"center\">%s</td><td>%d</td>\n</tr>\n",$row->Name,$row->Population);?></tbody</table><?php// Vérification du nombre de lignes luesprintf("<p>Lignes affectées : %d</p>\n",$link->affected_rows);}else# Sinon, affichage de l'erreurecho mysqli_error();// Libération du résultat et de l'objet de connexion$result->close();$link->close();?></body></html>Nous supposons que le processus du serveur Web peut atteindre l'IP du nœud SQL.

De manière similaire, vous pouvez utiliser l'API C de MySQL, ou les interfaces Perl-DBI, Python-mysql ou encore les connecteurs de MySQL AB pour effectuer les tâches de définition de données et de manipulations, comme vous le faites habituellement avec un serveur MySQL.

- N'oubliez pas que toutes les tables NDB doivent avoir une clé primaire. Si aucune clé primaire n'est définie par l'utilisateur lors de la création de la table, le moteur de stockage NDB va en générer une automatiquement. Note : cette clé cachée prend de l'espace, comme tout autre index. Il n'est pas rare de rencontrer des problèmes de mémoire lorsque vous devez prendre en compte ces clés automatiques.

16-3-6. Arrêt et redémarrage du cluster▲

Pour arrêter le cluster, utilisez simplement cette commande dans le Shell sur la machine qui héberge le serveur de gestion MGM :

shell> ndb_mgm -e shutdownCela va forcer les processus ndb_mgm, ndb_mgm et ndbd à s'arrêter proprement. Tous les nœuds SQL peuvent alors être arrêtés avec la commande mysqladmin shutdown classique ou par d'autres moyens.

Pour relancer le cluster, lancez simplement ces commandes :

-

sur l'hôte de gestion (192.168.0.10 dans notre cas) :

Sélectionnezshell>ndb_mgmd -f /var/lib/mysql-cluster/config.ini -

sur chaque nœud de stockage (192.168.0.30 et 192.168.0.40) :

Sélectionnezshell>ndbdN'oubliez pas d'invoquer cette commande avec l'option --initial lorsque vous redémarrez un nœud NDBD normalement.

- Et les hôtes SQL (192.168.0.20) :

shell> mysqld &Pour des informations sur les sauvegardes, voyez Section 16.6.4.2, « Utilisation du serveur de gestion pour une sauvegarde de cluster »Utilisation du serveur de gestion pour une sauvegarde de cluster.

Pour restaurer le cluster à partir de sauvegardes, il faut utiliser la commande ndb_restore. Vous pouvez vous informer là-dessus sur Section 16.6.4.3, « Comment restaurer une sauvegarde du cluster »Comment restaurer une sauvegarde du cluster.

Plus d'informations sur la configuration du cluster MySQL sont disponibles dans Section 16.4, « Configuration de MySQL Cluster »Configuration de MySQL Cluster.

16-4. Configuration de MySQL Cluster▲

Un serveur MySQL est une partie d'un cluster MySQL, et il ne diffère d'un serveur classique que d'un seul aspect : il dispose d'un moteur de stockage supplémentaire, à savoir : NDB ou NDBCLUSTER.

À part cela, le serveur MySQL n'est pas très différent de ceux que nous utilisons traditionnellement. Par défaut, le serveur est configuré sans le moteur NDB (pour éviter d'allouer des ressources inutiles). Pour activer NDB, vous devez modifier my.cnf.

De plus, comme le serveur MySQL est une partie du cluster, il doit savoir comment accéder au nœud MGM, pour connaître la configuration du cluster. Il y a un comportement par défaut qui recherche le nœud MGM sur le serveur local. Mais si vous devez le placer ailleurs, vous pouvez le taper en ligne de commande ou bien dans le fichier my.cnf. Avant que le moteur de stockage NDB ne soit utilisé, un nœud MGM est une base de nœud qui doit être active et accessible. Le seul nœud MGM est suffisant pour démarrer.

16-4-1. Compilation du cluster▲

NDB Cluster est disponible en distribution binaire depuis MySQL-Max 4.1.3.

Si vous décidez de compiler le cluster depuis les sources ou depuis MySQL 4.1 BitKeeper, assurez-vous d'utiliser l'option --with-ndbcluster avec la commande configure.

Vous pouvez aussi utiliser simplement le script BUILD/compile-pentium-max. Ce script inclut aussi OpenSSL, ce qui vous impose d'avoir OpenSSL installé ou de modifier le script de compilation pour l'exclure.

À part cela, vous pouvez suivre les instructions standard de compilation pour créer vos propres programmes, effectuer les tests et l'installation. Voir Section 2.4.3, « Installer à partir de l'arbre source de développement ».

16-4-2. Installation du logiciel▲

Il est plus facile de faire l'installation si vous avez déjà installé les serveurs de gestion (MGM) et les nœuds de bases (DB), et qu'ils sont actifs : cela sera sûrement la partie la plus longue de l'installation, en supposant que vous êtes déjà maitre de MySQL. Comme pour les fichiers de configuration et my.cnf, la structure du fichier est très claire, et cette section ne couvre que les différences spécifiques du cluster, par rapport à MySQL classique.

16-4-3. Vérification rapide du fonctionnement du cluster▲

Cette section montre comment configurer rapidement puis démarrer l'architecture la plus simple d'un cluster MySQL. Vous serez alors familiers avec les concepts de base. Puis, lisez les autres sections pour adapter plus finement votre installation.

Un dossier doit être créé. L'exemple utilise /var/lib/mysql-cluster. Exécutez la commande suivante, en tant que root :

shell> mkdir /var/lib/mysql-clusterDans ce dossier, créez un fichier config.ini avec le contenu suivant. Remplacez HostName et DataDir par les valeurs de votre installation.

# file "config.ini" - showing minimal setup consisting of 1 DB node,

# 1 management server, and 3 MySQL servers.

# The empty default sections are not needed, and are shown only for clarity.

# Storage nodes are required to provide a host name but MySQL Servers

# are not. Thus the configuration can be dynamic as to setting up the

# MySQL Servers.

# If you don't know the host name of your machine, use localhost.

# The DataDir parameter also has a default value, but it is recommended to

# set it explicitly.

# NDBD, MYSQLD, and NDB_MGMD are aliases for DB, API, and MGM respectively

#

[NDBD DEFAULT]

NoOfReplicas= 1

[MYSQLD DEFAULT]

[NDB_MGMD DEFAULT]

[TCP DEFAULT]

[NDB_MGMD]

HostName= myhost.example.com

[NDBD]

HostName= myhost.example.com

DataDir= /var/lib/mysql-cluster

[MYSQLD]

[MYSQLD]

[MYSQLD]Vous pouvez maintenant lancer le serveur de gestion. Pour cela, faites :

shell> cd /var/lib/mysql-cluster

shell> ndb_mgmdPuis, lancez un nœud de base, grâce au programme ndbd. Si c'est la toute première fois que vous lancez ndbd, utilisez l'option --initial :

shell> ndbd --initialLors des prochains appels à ndbd, ne l'utilisez plus.

shell> ndbdPar défaut, ndbd va rechercher le serveur de gestion sur localhost, port 2200.

Notez que si vous avez installé une distribution binaire, vous aurez besoin de spécifier explicitement le chemin des commandes ndb_mgmd et ndbd. Ils se trouvent dans le dossier /usr/local/mysql/bin.

Finalement, allez dans le dossier de données MySQL (il sera probablement dans /var/lib/mysql ou /usr/local/mysql/data). Assurez-vous que le fichier my.cnf contient les options nécessaires pour activer le moteur NDB Cluster :

[mysqld]

ndbclusterVous pouvez maintenant lancer le serveur MySQL comme d'habitude :

shell> mysqld_safe --user=mysql &Attendez un moment, et assurez-vous que le serveur fonctionne correctement. Si vous voyez un message « mysql ended », vérifiez le fichier d'erreur du serveur .err pour savoir ce qui se passe.

Si tout est bien allé, vous pouvez lancer le cluster :

shell> mysql

Welcome to the MySQL monitor. Commands end with ; or \g.

Your MySQL connection id is 1 to server version: 4.1.7-gamma

Type 'help;' or '\h' for help. Type '\c' to clear the buffer.

mysql> SHOW STORAGE ENGINES;

+------------+---------+------------------------------------------------------------+

| Engine | Support | Comment |

+------------+---------+------------------------------------------------------------+

...

| NDBCLUSTER | DEFAULT | Clustered, fault-tolerant, memory-based tables |

| NDB | YES | Alias for NDBCLUSTER |

...

mysql> USE test;

Database changed

mysql> CREATE TABLE ctest (i INT) ENGINE=NDBCLUSTER;

Query OK, 0 rows affected (0.09 sec)

mysql> show create table ctest \G

*************************** 1. row ***************************

Table: ctest

Create Table: CREATE TABLE `ctest` (

`i` int(11) default NULL

) ENGINE=ndbcluster DEFAULT CHARSET=latin1

1 row in set (0.00 sec)Si vous voulez vérifier que vos nœuds ont été correctement configurés, vous pouvez lancer le client de gestion :

shell> ndb_mgmEssayez d'utiliser la commande SHOW pour avoir un aperçu du cluster :

NDB> show

Cluster Configuration

---------------------

[ndbd(NDB)] 1 node(s)

id=2 @127.0.0.1 (Version: 3.5.3, Nodegroup: 0, Master)

[ndb_mgmd(MGM)] 1 node(s)

id=1 @127.0.0.1 (Version: 3.5.3)

[mysqld(API)] 3 node(s)

id=3 @127.0.0.1 (Version: 3.5.3)

id=4 (not connected, accepting connect from any host)

id=5 (not connected, accepting connect from any host)Le cluster est à vous !

16-4-4. Fichier de configuration▲

La configuration d'un cluster MySQL est placée dans un fichier de configuration. Ce fichier est lu par le serveur de gestion, puis distribué à tous les processus qui sont impliqués dans le cluster. Ce fichier contient la description de toutes machines impliquées dans le cluster, les paramètres de configuration pour les nœuds de stockage et les paramètres de configuration entre les nœuds.

16-4-4-1. Exemple de configuration d'un cluster MySQL▲

Actuellement, le fichier de configuration est au format INI, et il s'appelle config.ini par défaut. Il est placé dans le dossier de démarrage de ndb_mgmd, le serveur de gestion.

Les options préconfigurées sont disponibles pour la plupart des paramètres, et les valeurs par défaut peuvent être définies dans le fichier config.ini. Pour créer une section de valeurs par défaut, ajoutez le mot DEFAULT au nom de la section. Par exemple, les nœuds DB sont configurés avec la section [DB]. Si tous les nœuds DB utilisent la même quantité de mémoire, et que cette valeur n'est pas la valeur par défaut, alors créez une section [DB DEFAULT] qui contient le paramètre DataMemory, et qui spécifiera la valeur par défaut de la taille de mémoire des nœuds DB.

Le format INI est constitué de sections, précédées par des entêtes de sections (entourées de crochets), suivis de paramètres et leur valeur. Un changement par rapport au format standard est que le paramètre et sa valeur peuvent être séparés par un deux-points ':' en plus du signe égal '=', et un autre est que les sections ne sont pas uniques. Au lieu de cela, les entrées uniques comme deux nœuds du même type sont identifiées par un ID distinct.

Un fichier de configuration minimal doit définir les ordinateurs du cluster, et les nœuds impliqués, ainsi que les ordinateurs sur lesquels ces nœuds sont installés.

Un exemple de fichier de configuration minimal pour un cluster avec un serveur de gestion, deux serveurs de stockage et deux serveurs MySQL est présenté ci-dessous :

# file "config.ini" - 2 DB nodes and 2 mysqld

# This file is placed in the start directory of ndb_mgmd,

# the management server.

# The first MySQL Server can be started from any host and the second

# can only be started at the host mysqld_5.mysql.com

# NDBD, MYSQLD, and NDB_MGMD are aliases for DB, API, and MGM respectively

#

[NDBD DEFAULT]

NoOfReplicas= 2

DataDir= /var/lib/mysql-cluster

[NDB_MGMD]

Hostname= ndb_mgmd.mysql.com

DataDir= /var/lib/mysql-cluster

[NDBD]

HostName= ndbd_2.mysql.com

[NDBD]

HostName= ndbd_3.mysql.com

[MYSQLD]

[MYSQLD]

HostName= mysqld_5.mysql.comIl y a ici six sections dans le fichier. [COMPUTER] définit les ordinateurs du cluster. [API|MYSQLD] définit les nœuds de serveur MySQL du cluster. [MGM|NDB_MGMD] définit le serveur de gestion du cluster. [TCP] définit les connexions TCP/IP entre les nœuds du cluster, TCP/IP est le mécanisme de connexion par défaut entre deux nœuds. [SHM] définit les connexions par mémoire partagée entre les nœuds. Ce n'est possible que si les nœuds ont été compilés avec l'option --with-ndb-shm.

Pour chaque section, il est possible de définir un comportement par défaut, DEFAULT. Les paramètres sont insensibles à la casse depuis MySQL 4.1.5.

16-4-4-2. La chaîne connectstring du Cluster MySQL▲

À l'exception du serveur de gestion du cluster MySQL (ndb_mgmd), chaque nœud du cluster MySQL a besoin d'une chaîne connectstring qui pointe sur le serveur de gestion. Elle sert à établir la connexion avec le serveur de gestion, ainsi qu'à réaliser d'autres tâches en fonction du rôle du nœud dans le cluster. La syntaxe pour la chaîne connectstring est la suivante :

<connectstring> :=

[<nodeid-specification>,]<host-specification>[,<host-specification>]

<nodeid-specification> := nodeid=<id>

<host-specification> := <host>[:<port>]<id> est un entier plus grand que 1 qui identifie un nœud dans le fichier config.ini. <port> est un entier qui représente le port Unix. <host> est une chaîne qui est une adresse valide d'hôte Internet.

example 1 (long): "nodeid=2,myhost1:1100,myhost2:1100,192.168.0.3:1200"

example 2 (short): "myhost1"Tous les nœuds vont utiliser localhost:1186 comme chaîne par défaut, si elle n'est pas spécifiée. Si <port> est omis dans la chaîne, le port par défaut est 1186. (Note : avant MySQL 4.1.8, le port par défaut était 2200.) Ce port doit toujours être disponible sur le réseau, car il a été assigné par l'IANA pour cela (voyez http://www.iana.org/assignments/port-numbers pour les détails).

En listant plusieurs valeurs <host-specification>, il est possible de désigner plusieurs serveurs de gestion redondants. Un nœud de cluster va tenter de contacter successivement chaque serveur, dans l'ordre spécifié, jusqu'à ce qu'une connexion soit établie.

Il y existe plusieurs moyens de spécifier la chaîne connectstring :

- chaque programme a sa propre option de ligne de commande qui permet de spécifier le serveur de gestion au démarrage. Voyez la documentation respective de chaque programme ;

- depuis MySQL 4.1.8, il est aussi possible de configurer connectstring pour chaque nœud du cluster en plaçant une section [mysql_cluster] dans le fichier de configuration du serveur de gestion my.cnf ;

-

pour la compatibilité ascendante, deux autres options sont disponibles en utilisant la même syntaxe :

- Configurer la variable d'environnement NDB_CONNECTSTRING pour qu'elle contienne connectstring,

- Placez la chaîne connectstring pour chaque programme dans un fichier texte appelé Ndb.cfg et placez de fichier dans le dossier de démarrage.

La méthode recommandée pour spécifier la chaîne connectstring est de passer par la ligne de commande ou par le fichier my.cnf.

16-4-4-3. Définition des ordinateurs dans un cluster MySQL▲

La section [COMPUTER] n'a pas d'autre signification que de système de noms pour les nœuds du système. Tous les paramètres cités ici sont obligatoires.

- [COMPUTER]Id

C'est l'identité interne dans le fichier de configuration. Ultérieurement, on appellera cette entité un identifiant. C'est un entier. - [COMPUTER]HostName

Ceci est le nom d'hôte de l'ordinateur. Il est possible d'utiliser une adresse IP plutôt que son nom d'hôte.

16-4-4-4. Définition du serveur de gestion du cluster▲

La section [MGM] (et son alias [NDB_MGMD]) sert à configurer le comportement du serveur de gestion. Le paramètre obligatoire est soit ExecuteOnComputer, soit HostName. Tous les autres paramètres peuvent être omis, et ils prendront leur valeur par défaut.

- [MGM]Id

C'est l'identité du nœud, utilisée comme adresse dans les messages internes. C'est un entier compris entre 1 et 63. Chaque nœud du cluster a une identité unique. - [MGM]ExecuteOnComputer

Fait référence à un des ordinateurs définis dans la section COMPUTEUR. - [MGM]PortNumber

C'est le numéro de port que le serveur de gestion utilisera pour attendre les demandes de configuration et les commandes de gestion. -

[MGM]LogDestination

Ce paramètre spécifie la destination du log du cluster. Il y a plusieurs destinations possibles, et elles peuvent être utilisées en parallèle. Les valeurs possibles sont CONSOLE, SYSLOG et FILE. Pour les configurer, il faut les mettre sur une même ligne, séparés par des points-virgules ';'.

CONSOLE envoie sur la sortie standard, et aucun autre paramètre n'est nécessaire.SélectionnezCONSOLESYSLOG correspond à l'envoi log système. Il est nécessaire d'indiquer une méthode ici. Les méthodes possibles sont : auth, authpriv, cron, daemon, ftp, kern, lpr, mail, news, syslog, user, uucp, local0, local1, local2, local3, local4, local5, local6, local7. Notez que toutes ces options ne sont pas forcément supportées par tous les systèmes d'exploitation.

SélectionnezSYSLOG:facility=syslogFILE représente un fichier standard sur la machine. Il est nécessaire de spécifier un nom de fichier, la taille maximale du fichier avant l'ouverture d'un nouveau fichier. L'ancien sera alors renommé avec l'extension .x où x est le prochain nombre libre. Il est aussi nécessaire de spécifier le nombre maximal de fichiers utilisés.

SélectionnezFILE:filename=cluster.log,maxsize=1000000,maxfiles=6Il est possible de spécifier plusieurs destinations de logs comme ceci :

SélectionnezCONSOLE;SYSLOG:facility=local0;FILE:filename=/var/log/mgmdLa valeur par défaut de ce paramètre est FILE:filename=cluster.log,maxsize=1000000,maxfiles=6.

-

[MGM]ArbitrationRank

Ce paramètre est utilisé pour définir les nœuds qui servent d'arbitre. Les nœuds de gestion MGM et les nœuds API peuvent être utilisés comme arbitre. 0 signifie que le nœud n'est pas utilisé comme arbitre, 1 est la priorité haute, et 2 la priorité basse. Une configuration normale utilise les serveurs de gestion comme arbitre avec ArbitrationRank à 1 (c'est la valeur par défaut) et les nœuds d'API à 0 (ce n'est pas le défaut en MySQL 4.1.3). -

[MGM]ArbitrationDelay

Si vous donnez une valeur différente de 0 à cette option, cela signifie que le serveur de gestion retarde ses réponses d'autant, lorsqu'il reçoit des demandes d'arbitrage. Par défaut, il n'y a pas de délai, et c'est très bien comme ça. - [MGM]DataDir

C'est le dossier où les fichiers de résultats du serveur de gestion seront placés. Ces fichiers sont les fichiers de logs, les affichages de processus et le PID pour le démon.

16-4-4-5. Définitions des nœuds de stockage dans un cluster MySQL▲

La section [DB] et son alias [NDBD] servent à configurer le comportement des nœuds de stockage. Il y a de nombreux paramètres spécifiés qui contrôlent les tailles de buffer, les tailles de files ou les délais d'expiration, etc. Le seul paramètre obligatoire est soit ExecuteOnComputer ou HostName et le paramètre NoOfReplicas qui doit être défini dans la section [DB DEFAULT]. La plupart des paramètres doivent être dans la section [DB DEFAULT]. Seuls les paramètres explicitement présentés comme ayant une valeur locale peuvent être modifiés dans la section [DB]. HostName, Id et ExecuteOnComputer doivent être définies dans la section [DB].

La valeur de Id, ou l'identité d'un nœud de stockage peut être allouée au démarrage du nœud. Il est toujours possible d'assigner un identifiant dans un fichier de configuration.

Pour chaque paramètre, il est possible d'utiliser les suffixes k, M ou G, pour indiquer des multiples 1024, (1024*1024) et (1024* 1024*1024) de l'unité. Par exemple, 100 k représente 102 400. Les paramètres et leur valeur sont actuellement sensibles à la casse.

- [DB]Id

Cet identifiant est l'identité du nœud, utilisé pour référencer le nœud dans le cluster. C'est un entier compris entre 1 et 63. Chaque nœud du cluster doit avoir une identité distincte. - [DB]ExecuteOnComputer

Cela fait référence à un des ordinateurs définis dans la section 'Computer'. - [DB]HostName

Ce paramètre revient à spécifier un ordinateur sur lequel placer l'exécution. Il définit un nom d'hôte sur lequel réside le nœud de stockage. Ce paramètre ou ExecuteOnComputer est obligatoire. - [DB]ServerPort

Chaque nœud dans le cluster utilise un port pour se connecter avec les autres nœuds du cluster. Ce port est aussi utilisé pour les connexions lors de la phase de mise en place. Ce port par défaut sera utilisé pour s'assurer qu'aucun nœud sur le même ordinateur ne reçoit le même numéro de port. Le numéro de port minimum est 2202. - [DB]NoOfReplicas

Ce paramètre ne peut être configuré que dans la section [DB DEFAULT], car c'est un paramètre global. Il définit le nombre de répliques de chaque table stockée dans le cluster. Ce paramètre spécifie aussi la taille du groupe de nœuds. Un groupe de nœuds est un ensemble de nœuds qui stockent les mêmes informations.

Les groupes de nœuds sont formés implicitement. Le premier groupe est formé par les nœuds de stockage avec les identités les plus petites, puis par ordre d'identité croissante. Par exemple, supposons que nous avons quatre nœuds de stockage et que NoOfReplicas vaut 2. Les quatre nœuds de stockage ont les identifiants 2, 3, 4 et 5. Le premier groupe de nœuds sera formé par les nœuds 2 et 3, et le second groupe sera formé de 4 et 5. Il est important de configurer le cluster pour que les nœuds d'un même groupe ne soient pas placés sur le même ordinateur. Sinon, cela pourrait conduire à avoir un point de faiblesse : un seul ordinateur peut planter le cluster.

Si aucune identité n'est spécifiée, alors l'ordre des nœuds de stockage va être le facteur déterminant du groupe de nœuds. Le groupe de nœuds ainsi généré peut être affiché avec la commandeSHOWdans le client de gestion.

Il n'y a pas de valeur par défaut, et la valeur maximale est 4. - [DB]DataDir

Ce paramètre spécifie le dossier où les fichiers de traces, les fichiers de logs, et les fichiers d'erreurs sont rangés. - [DB]FileSystemPath

Ce paramètre spécifie le dossier où tous les fichiers créés pour stocker les métadonnées, les logs de REDO, les logs de UNDO et les fichiers de données sont rangés. La valeur par défaut est DataDir. Le dossier doit être créé avant de lancer le processus ndbd.

Si vous utilisez la hiérarchie de dossiers recommandée, vous utiliserez le dossier /var/lib/mysql-cluster. Sous ce dossier, un autre dossier ndb_2_fs sera créé (si l'identifiant de nœud est 2), pour servir de fichier système pour le nœud. - [DB]BackupDataDir

Il est possible de spécifier le dossier où les sauvegardes seront placées. Par défaut, le dossier FileSystemPath/BACKUP sera utilisé.

DataMemory et IndexMemory sont les paramètres qui spécifient la taille des segments de mémoire utilisés pour stocker les lignes et leur index. Il est important de comprendre comment DataMemory et IndexMemory sont utilisés pour comprendre comment choisir ces paramètres. Pour la majorité des cas, ils doivent être mis à jour pour refléter leur utilisation dans le cluster.

- [DB]DataMemory

Ce paramètre est l'un des paramètres les plus importants, car il définit l'espace disponible pour stocker les lignes dans la base de données. Tout l'espace DataMemory sera alloué en mémoire : il est donc important que la machine contienne assez de mémoire pour stocker DataMemory.

DataMemory sert à stocker deux choses. Il stocke les lignes de données. Chaque ligne est de taille fixe. Les colonnesVARCHARsont stockées sous forme de colonnes à taille fixe. De plus, chaque enregistrement est stocké dans une page de 32 ko avec 128 octets d'entête. Il y a donc un peu de pertes pour chaque page, car chaque ligne n'est stockée que sur une seule page. La taille maximale d'une colonne est actuellement de 8052 octets.

DataMemory sert aussi à stocker les index ordonnés. Les index ordonnés prennent environ 10 octets par ligne. Chaque ligne dans une table est représentée par un index ordonné.

DataMemory est constitué de pages de 32 ko. Ces pages sont allouées comme partitions pour les tables. Chaque table est généralement répartie en autant de partitions qu'il y a de nœuds dans le cluster. Par conséquent, il y a le même nombre de partitions (fragments) que la valeur de NoOfReplicas. Une fois qu'une page a été allouée, il n'est pas possible actuellement de la libérer. La méthode pour récupérer cet espace est d'effacer la table. Effectuer une restauration de nœuds va aussi compresser la partition, car toutes les lignes seront insérées dans une partition vide, depuis un autre nœud.

Un autre aspect important est que DataMemory contient aussi les informations de UNDO (annulation) pour chaque ligne. Pour chaque modification d'une ligne, une copie de la ligne est faite dans l'espace DataMemory. De plus, chaque copie va aussi avoir une instance dans l'index ordonné. Les index Hash unique sont modifiés uniquement lorsque les colonnes uniques sont modifiées dans ce cas, une nouvelle entrée est insérée dans la table. Au moment de l'archivage (commit), l'ancienne valeur est effacée. Il est donc nécessaire de pouvoir allouer la mémoire nécessaire pour gérer les plus grosses transactions effectuées dans le cluster.

Effectuer une transaction de grande taille n'a pas d'autre intérêt avec le Cluster MySQL que la cohérence, ce qui est la base des transactions. Les transactions ne sont pas plus rapides, et consomment beaucoup de mémoire.

La taille par défaut de DataMemory est 80 MB. La taille minimum est de 1 MB. Il n'y a pas de taille maximum, mais en réalité, il faut adapter la valeur pour éviter que le système n'utilise la mémoire sur le disque, par ce que la mémoire physique a été dépassée. - [DB]IndexMemory

IndexMemory est le paramètre qui contrôle la quantité d'espace utilisée pour les index hash de MySQL Cluster. Les index hash sont toujours utilisés pour les clés primaires, les index uniques et les contraintes d'unicité. En fait, lors de la définition d'une clé primaire et d'une clé unique, deux index distincts seront créés par MySQL Cluster. Un index sera un hash utilisé pour les accès aux lignes, et pour le verrouillage. Il est aussi utilisé pour les contraintes d'unicité.

La taille d'un index hash est de 25 octets plus la taille de la clé primaire. Pour les clés primaires dont la taille dépasse 32 octets, ajoutez un autre 8 octets pour des références internes.

Par exemple, observons la table suivante.

CREATE TABLE example

(

a INT NOT NULL,

b INT NOT NULL,

c INT NOT NULL,

PRIMARY KEY(a),

UNIQUE(b)

) ENGINE=NDBCLUSTER;Nous avons ici 12 octets d'entête (puisque des colonnes non nulles économisent 4 octets), plus 12 octets par ligne. De plus, nous avons deux index ordonnés sur les colonnes a et b, qui utilisent chacun 10 octets par ligne. Nous aurons aussi une clé primaire hash avec environ 29 octets par ligne. La contrainte unique est implémentée par une table séparée, avec b comme clé primaire et a comme colonne. Cette table va donc consommer encore 29 autres octets en mémoire par ligne, plus 12 octets d'entête et 8 octets pour les données.

Pour une table d'un million de lignes, nous aurons besoin de 58 Mo de mémoire pour gérer les index en mémoire, la clé primaire et la contrainte d'unicité. Pour DataMemory, nous aurons besoin de 64 Mo de mémoire, pour gérer les lignes de la table de base et celles de la table d'index, plus les deux tables d'index ordonnés.

En conclusion, les index hash consomment beaucoup d'espace en mémoire vive, mais fournissent un accès accéléré aux données. Ils sont aussi utilisés dans les clusters MySQL pour gérer les contraintes d'unicité.

Actuellement, les seuls algorithmes de partitionnement sont le hashage et les index ordonnés, qui sont locaux à chaque nœud, et ne peuvent pas prendre en compte les contraintes d'unicité en général.

Un point important pour les deux options IndexMemory et DataMemory est que le total de la base de données est la taille de DataMemory et IndexMemory dans chaque groupe. Chaque groupe est utilisé pour stocker les informations répliquées, ce qui fait que si vous avez 4 nœuds avec 2 répliques, cela fait 2 groupes de nœuds, et le total de DataMemory disponible est 2*DataMemory dans chaque nœud.

Un autre aspect important est les modifications de DataMemory et IndexMemory. Tout d'abord, il est fortement recommandé d'avoir la même quantité de DataMemory et IndexMemory sur tous les nœuds. Comme les données sont distribuées équitablement entre les nœuds du cluster, l'espace disponible n'est pas supérieur à la plus petite quantité d'espace disponible sur un des nœuds du cluster, multiplié par le nombre de groupe de nœuds.

DataMemory et IndexMemory peuvent être modifiés, mais il est dangereux de le réduire, car cela peut conduire à des problèmes de redémarrage pour un nœud, ou même pour le cluster, car il n'y aura plus assez de mémoire pour restaurer les tables. Accroître les valeurs doit être facile à faire, mais il est recommandé, pour ce type de mise à jour, de faire une modification comparable à une mise à jour du logiciel : modification du fichier de configuration, puis redémarrage du serveur de gestion, et chaque serveur est relancé manuellement, un à la fois.

IndexMemory n'est pas utilisé à cause des modifications, mais à cause des insertions : ces dernières sont insérées immédiatement, alors que les effacements ne sont pris en compte que lorsque la transaction est archivée.

La valeur par défaut de IndexMemory est 18 Mo. La taille minimale est de 1 Mo.

Les trois paramètres suivants sont importants, car ils affectent le nombre de transactions simultanées et la taille des transactions qui peuvent être gérées par le système. MaxNoOfConcurrentTransactions fixe le nombre de transactions simultanées dans un nœud, et MaxNoOfConcurrentOperations fixe le nombre de lignes qui peuvent être en phase de modification ou de verrouillage simultanément.

Ces deux paramètres, et particulièrement MaxNoOfConcurrentOperations seront étudiés de près par les utilisateurs qui choisissent des valeurs particulières, et évitent les valeurs par défaut. La valeur par défaut est configurée pour les systèmes ayant de petites transactions, et s'assure que la mémoire n'est pas trop sollicitée.

- [DB]MaxNoOfConcurrentTransactions

Pour chaque transaction active dans le cluster, il y a besoin d'une ligne de transaction dans l'un des nœuds du cluster. Le rôle de cette coordination de transaction est réparti entre tous les nœuds et ainsi, le nombre de lignes de transactions dans le cluster est le nombre de nœuds dans le cluster.

En fait, les lignes de transactions sont allouées aux serveurs MySQL. Normalement, il y a au moins une ligne de transaction allouée dans le cluster par connexion qui utilise ou a utilisé une table dans le cluster. Par conséquent, il faut s'assurer qu'il y a plus de lignes de transaction dans le cluster qu'il n'y a de connexions simultanées à tous les serveurs du cluster MySQL.

Ce paramètre doit être le même pour tous les nœuds du serveur.

Modifier ce paramètre n'est jamais facile, et peut conduire à un crash du système. Lorsqu'un nœud crashe, le nœud le plus ancien va prendre en charge l'état des transactions qui avaient lieu dans le nœud perdu. Il est donc important que ce nœud ait autant de lignes de transactions que le nœud perdu.

La valeur par défaut pour ce paramètre est 4096. - [DB]MaxNoOfConcurrentOperations

Ce paramètre est sujet à modifications par les utilisateurs. Les utilisateurs qui effectuent des transactions courtes et rapides n'ont pas besoin de lui donner une valeur trop haute. Les applications qui veulent utiliser des transactions de grande taille impliquant de nombreuses lignes devront accroître sa valeur.

Pour chaque transaction qui modifie des données dans le cluster, il faut allouer des lignes d'opération. Il y a des lignes d'opération au niveau de la coordination de transaction, et dans les nœuds où les transformations ont lieu.

Les lignes d'opération contiennent des informations d'état qui doivent être capables de retrouver des lignes d'annulation, des files de verrous et toutes les autres informations d'état.

Pour dimensionner le cluster afin de gérer des transactions où un million de lignes doivent être mises à jour simultanément, il faut donner à ce paramètre la valeur d'un million divisé par le nombre de nœuds. Pour un cluster ayant 4 nœuds de stockage, la valeur sera donc de 250 000.

De plus, les lectures qui posent des verrous utilisent aussi des lignes d'opération. De la mémoire supplémentaire est allouée dans les nœuds locaux pour gérer les cas où la distribution n'est pas parfaite entre les nœuds.

Lorsqu'une requête impose l'utilisation d'un index hash unique, il y aura automatiquement deux lignes d'opération pour chaque ligne de la transaction. La première représente la lecture dans la table d'index, et la seconde gère l'opération dans la table de base.

La valeur par défaut pour ce paramètre est 32 768.

Ce paramètre gère en fait deux aspects qui peuvent être configurés séparément. Le premier aspect spécifie le nombre de lignes d'opération qui peuvent être placées dans la coordination de transaction. Le second aspect spécifie le nombre de lignes d'opération qui seront utilisées dans la base de données locale.

Si une très grande transaction est effectuée sur un cluster de 8 nœuds, elle aura besoin d'autant de lignes d'opération pour la coordination de transactions qu'il y a de lectures, modifications et effacements impliqués dans la transaction. La transaction va répartir les lignes d'opération entre les 8 nœuds. Par conséquent, s'il est nécessaire de configurer le système pour une grosse transaction, il est recommandé de configurer les nœuds séparément. MaxNoOfConcurrentOperations va toujours être utilisé pour calculer le nombre de lignes d'opération dans la coordination de transaction.

Il est aussi important d'avoir une idée des contraintes de mémoire pour ces lignes d'opération. En MySQL 4.1.5, les lignes d'opération consomment 1 Ko par ligne. Ce chiffre est appelé à réduire dans les versions 5.x. - [DB]MaxNoOfLocalOperations

Par défaut, ce paramètre est calculé comme 1,1 fois MaxNoOfConcurrentOperations ce qui est bon pour les systèmes avec de nombreuses requêtes simultanées, de petite taille. Si la configuration doit gérer une très grande transaction une fois de temps en temps, et qu'il y a de beaucoup de nœuds, il est alors recommandé de configurer cette valeur séparément.

Le jeu de paramètres suivant est utilisé pour le stockage temporaire durant l'exécution d'une requête dans le cluster. Toute cette mémoire sera libérée lorsque la requête sera terminée, et que la transaction attendra l'archivage ou l'annulation.

La plupart des valeurs par défaut de ces paramètres seront valables pour la plupart des utilisateurs. Certains utilisateurs exigeants pourront augmenter ces valeurs pour améliorer le parallélisme du système, et les utilisateurs plus contraints pourront réduire les valeurs pour économiser de la mémoire.

- [DB]MaxNoOfConcurrentIndexOperations

Pour les requêtes utilisant un index unique hash, un autre jeu de lignes d'opération sont temporairement utilisés durant la phase d'exécution de la requête. Ce paramètre configure la taille de la file qui accueille ces lignes. Par conséquent, cette mémoire n'est utilisée que lors de l'exécution d'une requête, et dès la fin de l'exécution, les lignes sont libérées. L'état nécessaire pour gérer les annulations et archivages est géré par les lignes d'opération permanentes, où la taille de la file est gérée par MaxNoOfConcurrentOperations.

La valeur par défaut pour ce paramètre est 8192. Seules les situations où un très haut niveau de parallélisme utilisant des index uniques hash doivent augmenter cette valeur. La réduction de cette valeur permet d'économiser de la mémoire, si l'administrateur est certain que le parallélisme reste rare dans le cluster. - [DB]MaxNoOfFiredTriggers

La valeur par défaut pour MaxNoOfFiredTriggers est 4000. Normalement, cette valeur doit être suffisante pour la plupart des systèmes. Dans certains cas, il est possible de réduire cette valeur si le parallélisme n'est pas trop haut dans le cluster.

Cette option est utilisée lorsqu'une opération est effectuée, et affecte un index hash unique. Modifier une colonne qui fait partie d'un index unique hash ou insérer/effacer une ligne dans une table avec un index unique hash va déclencher une insertion ou un effacement dans l'index de la table. Cette ligne est utilisée durant l'attente de la fin de l'exécution de cette opération. C'est une ligne qui ne dure pas longtemps, mais elle peut malgré tout réclamer plusieurs lignes pour des situations temporaires d'écritures parallèles sur la table de base, contenant les index uniques. - [DB]TransactionBufferMemory

Ce paramètre est aussi utilisé pour lister les opérations de modifications d'index. Elle garde les informations de clé et colonne de l'opération en cours. Il doit être exceptionnel de modifier ce paramètre.

De plus, les opérations de lecture et écriture utilisent un buffer similaire. Ce buffer est encore plus temporaire dans son utilisation, ce qui fait que c'est un paramètre de compilation, qui vaut 4000*128 octets (500Ko). Le paramètre st ZATTRBUF_FILESIZE dans Dbtc.hpp. Un buffer similaire pour les informations de clé, qui représente 4000*16 octets, soit 62.5 ko d'espace. Ce paramètre est ZDATABUF_FILESIZE dans Dbtc.hpp. Dbtc est le module qui gère la coordination de transaction.

Des paramètres similaires existent dans le module Dblqh pour gérer les lectures et modifications lorsque les données ont été localisées. Dans Dblqh.hpp avec ZATTRINBUF_FILESIZE qui vaut 10000*128 octets (1250 ko) et ZDATABUF_FILE_SIZE, qui vaut 10000*16 octets (environ 156 ko). Nous n'avons aucune connaissance de situation qui soit limitée par ces valeurs.

La valeur par défaut de TransactionBufferMemory est 1 Mo. - [DB]MaxNoOfConcurrentScans

Ce paramètre est utilisé pour contrôler la quantité de scans parallèles qui sont effectués dans le cluster. Chaque coordination de transaction peut gérer un certain nombre de scans de tables simultanément, et ce nombre est limité par cette option. Chaque partition va utiliser une ligne de scan dans le nœud où la partition est située. Le nombre de lignes est la taille de ce paramètre multiplié par le nombre de nœuds, ce qui fait que le cluster peut supporter le nombre maximal de scans, multiplié par le nombre de nœuds du cluster.

Les scans sont effectués dans deux situations. La première est lorsqu'aucun index hash ou ordonné n'a pu être trouvé pour gérer la requête. Dans ce cas, la requête est exécutée avec un scan de table. La seconde est lorsqu'il n'y a pas d'index hash, mais seulement un index ordonné. Utiliser l'index ordonné, revient à faire un scan de tables parallèles. Comme l'ordre n'est conservé que dans les partitions locales, il est nécessaire de faire le scan dans toutes les partitions.

La valeur par défaut de MaxNoOfConcurrentScans est 256. La valeur maximale est de 500.

Ce paramètre va toujours spécifier le nombre de scans possibles dans la coordination de transaction. Si le nombre local de scans n'est pas fourni, il est calculé comme le produit de MaxNoOfConcurrentScans et du nombre de nœuds de stockages du système. - [DB]MaxNoOfLocalScans

Il est possible de spécifier le nombre de lignes de scan locaux, si les scans ne sont pas totalement parallèles. - [DB]BatchSizePerLocalScan

Ce paramètre est utilisé pour calculer le nombre de lignes de verrous qui est nécessaire pour gérer les opérations de scan courantes.

La valeur par défaut est 64 et cette valeur est très liée au paramètre ScanBatchSize défini dans l'interface des nœuds. - [DB]LongMessageBuffer

Ceci est un buffer interne utilisé pour passer des messages aux nœuds, et entre les nœuds. Il est hautement improbable que quiconque veuille modifier cette valeur, mais il est malgré tout disponible. Par défaut, ce paramètre vaut 1 Mo. - [DB]NoOfFragmentLogFiles

Ceci est un paramètre important qui indique la taille du fichier de logs de REDO. Les logs REDO sont organisés en boucle, et il est important que la fin et le début ne se chevauchent pas. Lorsque la queue et la tête se rapprochent dangereusement l'un de l'autre, le nœud va commencer à annuler les modifications, car il n'y a plus de place pour les lignes de modifications.

Le log de REDO n'est supprimé que lorsque trois jalons locaux sont passés depuis l'insertion dans le log. La vitesse d'apparition d'un jalon est contrôlée par un jeu de paramètres : tous ces paramètres sont donc liés.

La valeur par défaut de ce paramètre est 8, ce qui signifie que 8 jeux de 4*16 Mo fichiers. Cela représente un total de 512 Mo. L'unité de stockage est de 64 Mo pour le log de REDO. Dans les serveurs à fort taux de modification, il faut augmenter considérablement cette valeur. Nous avons vu des cas de test où il a fallu mettre cette valeur à plus de 300.

Si les jalons sont lents à venir, et qu'il y a tellement d'écritures dans la base que les fichiers de logs sont remplis, que le fichier de logs de queue ne peut pas être supprimé pour assurer la restauration, les transactions de modification seront interrompues avec une erreur interne 410, qui sera transformée en message : Out of log file space temporarily. Cette condition restera en place jusqu'à ce qu'un jalon soit atteint, et que la queue du log puisse avancer. - [DB]MaxNoOfSavedMessages

Ce paramètre limite le nombre de fichiers de trace qui seront conservés sur le serveur, avant de remplacer un ancien fichier de trace. Les fichiers de trace sont générés lorsque le nœud crashe pour une raison donnée.

La valeur par défaut est de 25 fichiers de trace.

Le jeu de paramètres suivant définit la taille du buffer d'objets de métadonnées. Il est nécessaire de définir le nombre maximal d'objets, d'attributs, d'index et d'objets triggers utilisés par les index, les événements, et la réplication entre clusters.

- [DB]MaxNoOfAttributes

Ce paramètre définit le nombre d'attributs qui peuvent être définis dans le cluster.

La valeur par défaut pour ce paramètre est 1000. La valeur minimale est 32 et il n'y a pas de maximum. Chaque attribut consomme environ 200 octets d'espace, car les métadonnées sont totalement répliquées entre les nœuds. - [DB]MaxNoOfTables

Un objet de table est alloué pour chaque table, pour chaque index hash unique et pour chaque index ordonné. Ce paramètre fixe le nombre maximal d'objets de table qui soit alloué.

Pour chaque attribut qui contient un type de donnéesBLOB, une autre table est utilisée pour stocker la partie principale des donnéesBLOB. Ces tables doivent aussi être prises en compte lorsque vous définissez les tables.

La valeur par défaut pour ce paramètre est 128. La valeur minimale est de 8, et il n'y a pas de maximum. Il y a des limitations internes, qui empêchent d'aller au-delà de 1600. Chaque objet de table consomme environ 20 ko de mémoire par nœud. - [DB]MaxNoOfOrderedIndexes

Pour chaque index ordonné dans le cluster, des objets sont alloués pour décrire ce qu'ils indexent et leur stockage. Par défaut, chaque index défini aura un index ordonné associé. Les index uniques et les clés primaires ont tous deux un index ordonné et un index hash.

La valeur par défaut pour ce paramètre est 128. Chaque objet consomme environ 10 ko par nœud. - [DB]MaxNoOfUniqueHashIndexes

Pour chaque index unique (pas pour les index primaires), une table spéciale est allouée pour assurer la correspondance entre la clé primaire et la clé unique de la table indexée. Par défaut, il y aura un index ordonné de défini pour chaque index unique. Pour éviter cela, utilisez l'optionUSINGHASH.

La valeur par défaut de 64. Chaque index va consommer environ 15 ko par nœud. - [DB]MaxNoOfTriggers

Pour chaque index hash unique, un trigger interne de modification, insertion ou effacement est alloué. Cela fait 3 triggers pour chaque index hash unique. Les index ordonnés utilisent un seul objet trigger. Les sauvegardes utilisent aussi trois objets trigger pour chaque table normale dans le cluster. Lorsque la réplication entre cluster est supportée, elle va aussi utiliser un trigger interne.

Ce paramètre limite le nombre d'objets trigger dans le cluster.

La valeur par défaut pour ce paramètre est 768. - [DB]MaxNoOfIndexes

Ce paramètre est abandonné depuis MySQL 4.1.5. Il faut désormais utiliser MaxNoOfOrderedIndexes et MaxNoOfUniqueHashIndexes à la place.

Ce paramètre ne sert que pour les index hash uniques. Il faut une ligne dans ce buffer pour chaque index hash unique défini dans le cluster.

La valeur par défaut pour ce paramètre est 128.

Il y a un jeu de paramètres booléens qui affectent le comportement des nœuds de stockage. Les paramètres booléens peuvent être spécifiés à true avec Y (pour Yes, c'est-à-dire oui) ou 1, et à false avec N (pour non) ou 0.

- [DB]LockPagesInMainMemory

Pour certains systèmes d'explications tels que Solaris et Linux, il est possible de verrouiller un processus en mémoire et éviter les problèmes de swap. C'est une fonctionnalité importante pour améliorer le temps réel du cluster.

Par défaut, cette fonctionnalité n'est pas activée. - [DB]StopOnError

Ce paramètre indique si le processus doit s'arrêter sur une erreur, ou s'il doit faire un redémarrage automatique.

Par défaut, cette fonctionnalité est activée. - [DB]Diskless

Dans les interfaces internes, il est possible de configurer les tables comme sans disque (littéralement, diskless), ce qui signifie que les tables ne sont pas enregistrées sur le disque, et qu'aucun log n'est fait. Ces tables existent uniquement en mémoire. Ces tables existeront encore après un crash, mais pas leur contenu.

Cette fonctionnalité fait que le cluster entier devient Diskless, ce qui fait que les tables n'existent plus après un crash. Activer cette fonctionnalité de fait avec Y ou 1.

Lorsque cette fonctionnalité est activée, les sauvegardes sont faites, mais elles ne seront pas stockées, car il n'y a pas de disque. Dans les versions futures, il est probable que les sauvegardes sans disques soient une option séparée.

Par défaut, cette fonctionnalité n'est pas activée. - [DB]RestartOnErrorInsert

Cette fonctionnalité n'est possible que lorsque la version de débogage a été compilée, pour pouvoir insérer des erreurs à différents points de l'exécution, afin de tester les cas d'erreurs.

Par défaut, cette fonctionnalité n'est pas activée.

Il y a plusieurs paramètres pour tester les délais d'expiration et les intervalles entre différentes actions des nœuds de stockage. Plusieurs délais d'expiration sont spécifiés en millisecondes, à quelques exceptions qui sont explicitement indiquées.

- [DB]TimeBetweenWatchDogCheck

Pour s'assurer que le thread principal ne reste back éternellement bloqué dans une boucle infinie, il existe un garde-fou qui vérifie le fonctionnement de ce thread. Ce paramètre indique le nombre de millisecondes entre deux vérifications. Après trois essais où le processus est dans le même état, le thread est arrêté par le garde-fou.

Ce paramètre peut être facilement modifié, et peut différer de nœud en nœud, même s'il y a peu de raison pour faire des traitements différents.

La durée par défaut est de 4000 millisecondes (4 secondes). - [DB]StartPartialTimeout

Ce paramètre spécifie le temps durant lequel le cluster attend les nœuds de stockage avant que l'algorithme de cluster soit appelé. Cette durée est appelée pour éviter de démarrer un cluster partiel.